RMSprop(Root Mean Square Propagation)は、

Adagradでの学習率がゼロに収束してしまう問題を解決した手法です。

ニューラルネットワークの最適化アルゴリズムの一つで、勾配降下法の進化版です。RMSpropは、学習率の調整と勾配の分散を制御するために提案されました。

以下にRMSpropの要点を説明します。

- 指数移動平均の使用:

RMSpropは、過去の勾配の情報を保持し、それを指数移動平均を用いて追跡します。これにより、過去の勾配の大きさの変動を考慮しつつ、学習率を適応的に調整します。 - 学習率の調整:

RMSpropは、学習率を各パラメータごとに個別に調整します。過去の勾配の二乗平均(勾配の分散)を指数移動平均で計算し、これを学習率の分母に用いることで、学習率を調整します。このため、急激な勾配の変動に対しては学習率が小さくなり、緩やかな勾配の変動に対しては学習率が大きくなります。 - 更新式:

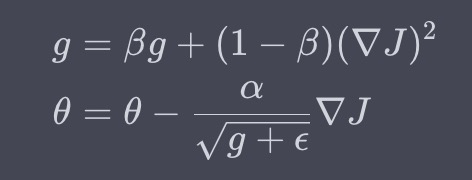

RMSpropのパラメータ更新式は以下のように表されます

(\(\alpha\)は学習率、\(\epsilon\)は数値安定性のための小さな値、\(g\)は勾配の二乗平均)

RMSpropは、学習率の調整を通じて非定常な学習率問題を軽減し、勾配の急激な変動に対しても安定した最適化を行うことができます。その後のアルゴリズム(例: Adam)の基盤となるアイデアが含まれており、実用的な最適化手法の一つとして広く使われています。