E資格でもよく出題される

A3C(Asynchronous Advantage Actor-Critic)について解説します。

2016年にDeepMind社のVolodymyr Mnihによって提案

原案論文はこちら

A3Cの特徴:複数のエージェントが同じ環境で非同期に学習

名称”Asynchronous Advantage Actor-Critic”にある3つの”A”は

「Asynchronous」

「Advantage」

「Actor」

を表し、

”C”は「Critic」を表します。

synchronous Advantage Actor-Critic

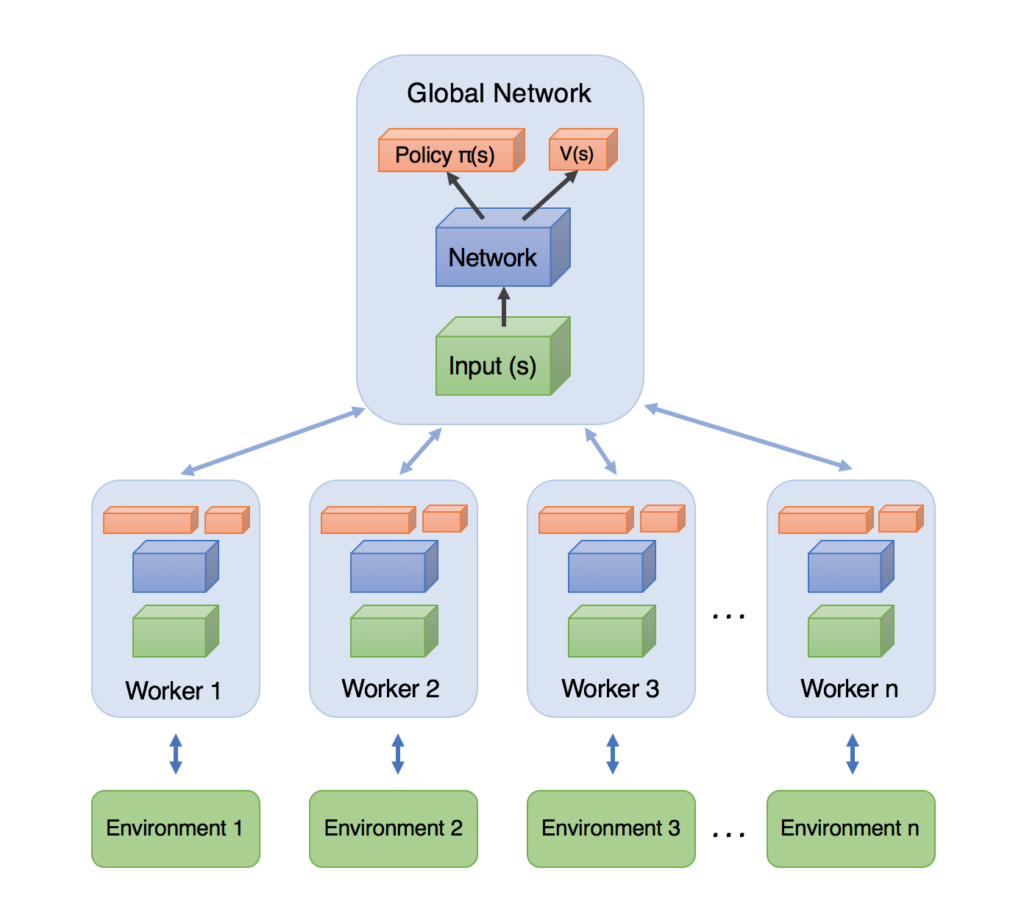

各workerが個別に計算する

workerが計算した勾配で中央のネットワークが学習

定期的に中央からworkerに重みがコピーされる

初期に提案されたものなのでシンプルだが結構性能が良い

メリット

workerが独立なので多様性が期待できる

方策オンでもオフでも関係ない

RNNなども自由に使える

A3C(Asynchronous Advantage Actor-Critic)は、

深層強化学習におけるアルゴリズムの一つで、非同期な並列トレーニングに基づく強化学習手法です。

A3Cは、複数のエージェントが同時に異なる環境で学習し、それぞれのエージェントの経験を共有することによって学習を効率的に進める方法です。

A3Cのキーのアイディアは、アクター(ポリシー)とクリティック(価値関数)のネットワークを非同期に更新することです。

アクターは方策を近似し、行動を選択する役割を果たし、クリティックは状態の価値を推定する役割を果たします。

以下にA3Cの基本的な要点を説明します。

- エージェントと環境:

エージェントは強化学習の主体であり、環境とやり取りしながら学習を進めます。エージェントは状態を観測し、その状態に基づいて行動を選択します。 - アクター(ポリシー)ネットワーク:

アクターネットワークは方策を近似するためのネットワークで、状態を入力として受け取り、各行動の確率分布を出力します。アクターネットワークの更新によって、エージェントの行動戦略が最適化されます。 - クリティック(価値関数)ネットワーク:

クリティックネットワークは状態価値を推定するためのネットワークで、状態を入力として受け取り、その状態の価値を出力します。クリティックネットワークの更新によって、エージェントは行動の価値を評価します。 - アドバンテージ関数:

A3Cでは、アクターネットワークから予測される行動の価値と、クリティックネットワークから予測される状態価値の差をアドバンテージ関数として用います。これにより、エージェントは行動の相対的な価値を評価し、方策の更新に使用します。 - 非同期トレーニング:

複数のエージェントが異なる環境で並列に学習を行います。各エージェントは独立にエピソードを収集し、共有メモリを通じてアクターネットワークとクリティックネットワークを非同期に更新します。

A3Cは、並列トレーニングとアドバンテージ関数の導入により、効率的な強化学習が可能な手法として知られています。